БИБЛИОМЕТРИЯ

УДК 002.53/. 55

А. И. Земсков

Библиометрия: взгляд на проблему.

Сравнение уровня цитирования научных статей

в разных странах

Аналитический обзор материалов, опубликованных зарубежными коллегами в последние три года.

Ключевые слова: библиометрия, цитирование, индекс цитируемости, научная деятельность, университетская наука.

На заседании Совета по науке и образованию 30 апр. 2013 г. Президент Российской Федерации В. В. Путин сказал: «Нам нужно выстроить систему объективного анализа работы научных организаций (в свою очередь я также хочу подчеркнуть – национальную систему объективной оценки работы научных организаций), наряду с ведомственной оценкой активно привлекать профессиональных экспертов. Причём система оценки должна действовать на уровне как научных учреждений, так и их структурных подразделений: отделов, лабораторий и так далее. Это позволит сконцентрировать государственные средства на тех направлениях, где мы можем сказать действительно веское новое слово, получить многообещающие результаты, востребованные нашим обществом и экономикой страны».

На эту же тему высказался и президент РАН академик В. Е. Фортов в своей предвыборной программе: «Существенный критерий оценки научной деятельности – число публикаций в научных журналах и индекс цитируемости этих публикаций. Ясно, что критерии должны быть разными для разных областей знаний. Особые критерии должны быть разработаны для учёных и организаций, ведущих масштабные экспериментальные, прикладные и оборонные работы».

В связи с этим неудивительно, что в программу международной конференции «Информационные технологии, компьютерные системы и издательская продукция для библиотек» («ЛИБКОМ»; 11–16 ноября 2013 г., Суздаль) был включён «круглый стол» «Библиометрия. Взгляд на проблему». Это мероприятие организовала и провела директор Центра аналитических и маркетинговых исследований, развития и формирования проектов в рамках целевых программ ГПНТБ России доктор техн. наук В. А. Цветкова. Она же выступила с объединённым докладом «Библиометрия как один из подходов к оценке научно-исследовательской сферы» (соавтор – В. А. Маркусова).

На этом заседании мне было поручено проанализировать препятствия на пути использования библиометрии, поэтому достаточно критический характер последующих моих примеров и рассуждений следует трактовать как выполнение командировочного задания.

Несколько лет назад руководители российской науки уже осознали бесперспективность «равномерного» распределения средств между научными учреждениями и приступили к формулированию целевых программ и адресной поддержке определённых тематик.

Надо признать, что объективные причины для беспокойства существуют. Последние 15–20 лет российская наука продолжает неуклонно терять свои позиции, если это измерять в терминах количества и качества научных публикаций, их цитируемости, а также в рейтингах университетов. По-видимому, дело не только в недостаточном финансировании науки или в неготовности российского бизнеса поддерживать прикладные научные исследования.

Развитые страны – Япония, США, Германия, Великобритания, Франция, Южная Корея, Австралия – имеют более высокую долю расходов на НИОКР относительно валового национального продукта (ВНП), по сравнению с тем, что могут позволить себе другие страны. Более детальное изучение показывает, что в этих странах значительную часть расходов на НИОКР даёт бизнес: например, по данным 2008 г. в Японии – 78,2%; в США – 67,3%; в Германи – 67,6%; в Великобритании – 45,1%.

После проведения экономических реформ в России значительная часть наиболее талантливой, творчески настроенной молодёжи уезжает работать за рубеж; доля учёных старшего поколения заметно возросла, что неизбежно влечёт за собой усиление традиционных, хорошо освоенных методов научных исследований, но не обращение к новым подходам.

Создаётся впечатление, что чем больше слов про «инновации» произносится на высоком уровне, чем больше средств вкладывается в национальные проекты типа Сколково, тем хуже (по объективным данным объёмов научных публикаций, доли российской науки в мировом потоке научных публикаций и уровню цитирования) идут реальные дела. Проект Сколково, задуманный как центр коммерциализации и внедрения научных достижений, пока что не приносит особых научных результатов, – попросту говоря, внедрять пока что нечего, и чем конкретно занимаются в Сколково, научному сообществу неизвестно, – информирование поставлено плохо.

Конечно, сказалось и наследие специфически советского отношения к научным публикациям. Я помню, как в то время непременным условием отправки публикации в советский научный журнал было наличие справки (заключения) Экспертного совета предприятия, ключевая фраза которой звучала примерно так: «Работа тов. Иванова не содержит сведений, составляющих предмет государственной тайны, не содержит элементов новизны и может быть опубликована в открытой печати». Компилятивность, отсутствие новизны в публикациях сыграли свою негативную роль.

Сразу же после отмены всех видов цензуры мы в ГПНТБ России испытали буквально взрыв интереса к российским научно-техническим разработкам, отражённым в прежде недоступных источниках: Франция, Республика Корея охотно закупали нашу базу данных «серой» (малотиражной) литературы. Интерес к сотрудничеству проявляли Германия и другие развитые страны. Но всё это довольно быстро кончилось и, похоже, наши партнёры со временем поняли: ничего особенно примечательного в прежде закрытой для внешнего мира советской системе публикаций по науке и технике не существует.

Присутствие вузов страны в международных рейтингах университетов (таких, например, как ARWU – Academic Ranking of World Universities, созданный и поддерживаемый Шанхайскиим университетом, или мировой рейтинг университетов THE – The Times Higher Education World University Rankings – система оценок, поддерживаемая компанией «Thomson Reuters») также во многом зависит от уровня цитируемости и, конечно, определённым образом отражает научный авторитет страны.

Во всех рейтингах первые места представлены одним и тем же набором – двадцати американских университетов и четырёх-пяти английских. В табл. 1 показаны международные рейтинги университетов стран БРИК (Бразилия, Россия, Индия, Китай) и МИСТ (Мексика, Индонезия, Южная Корея, Турция). В дополнение заметим, что в рейтинге THE за 2012–2013 гг. 201–225 места делят с другими (зарубежными) вузами МГУ (Lomonosov Moscow State University) и МИФИ (Moscow State Engineering Physics Institute) 226–250. По рейтингу ARWU 301–400 места делит СПГУ(Saint Petersburg State University), получивший здесь 27,8 балла за мнение выпускников университета, и занимающий 2-е место в национальном рейтинге университетов. Итак, положение наших университетов в мире – незавидное.

Таблица 1

Международные рейтинги университетов стран БРИК и МИСТ

|

Страна |

Рейтинг ARWU, |

Рейтинг THE, |

||

|

|

2003 г. |

2010 г. |

2004 г. |

2010 г. |

|

Бразилия |

4 |

7 |

0 |

2 |

|

Россия |

0 |

2 |

1 |

2 |

|

Индия |

1 |

2 |

0 |

1 |

|

Китай |

12 |

29 |

6 |

16 |

|

Мексика |

1 |

1 |

0 |

0 |

|

Индонезия |

нет данных |

0 |

0 |

|

|

Турция |

1 |

1 |

0 |

0 |

|

Южная Корея |

8 |

10 |

3 |

4 |

Если говорить о фундаментальных исследованиях, то роль Академии наук (АН СССР, затем РАН) падала на протяжении многих лет. На рисунках 1 и 2 показана доля публикаций Академии относительно доли других российских научных организаций (Институт атомной энергии им. И. В. Курчатова, Всероссийский институт экспериментальной физики в Сарове и др.) и доли работ университетских учёных среди публикаций в журналах «Nature» (рис. 1) и «Physical Review Letters» (рис. 2). Источникпредставленныхданных – доклад «Where natural sciences (physics) made in the world and in Russia: 3-decades Dynamics», Michael Romanovsky, A. M. Prokhorov General Physics Institute, Moscow, Russia, прозвучавший на 14-й конференции Международного общества наукометрии и информетрии (The 14th International Society of Scientometrics and Informetrics Conference University of Vienna 15–19 July 2013). Труды этой конференции – 2200 с. – дают богатейший фактический материал для анализа и сопоставления. Далее в статье для краткости буду называть её Венская конференция.

Рис. 1. Доля публикаций РАН и

других российских научных организаций

в журнале «Nature» (в %)

Рис. 2. Доля публикаций РАН и других российских научных учреждений

в журнале «PhysicalReviewLetters» (в %)

В обзоре «Анализ научной деятельности организации и роль библиотек» Олег Уткин (Oleg.utkin@thomsonreuters.com), менеджер по работе с ключевыми клиентами компании «Thomson Reuters», приводит данные о динамике доли российских научных публикаций в мировом потоке научных публикаций за 1994–2011 гг. (рис. 3).

Рис. 3. Динамика доли российских

научных публикаций

в мировом потоке научных публикаций за 1994–2011 гг.

(источник: Web of Science SCIE, SSCI, AHCI, CPCI, BKCI, по состоянию на 23.05.2012; оригинал рисунка: http://wokinfo.com/media/pdf/ru-analysis_of_rd_activities.pdf). Перечень российских журналов, включённых в Web of Science, WoS можно найти по адресу http://srd.nsu.ru/website/nich/var/custom/File/wos_rus_journals.pdf

Заметим, что в развитых странах акцент делается на количестве получаемых патентов, а не только опубликованных статей (так называемая модель Альбукерке – Albuquerque’s Model – по имени её автора Эдуардо де ла Мотта э Альбукерке – Eduardo da Motta e Albuquerque – из федерального университета г. Белу Оризонте, Бразилия. Эту модель он поместил в главе 34 «Справочника количественной науки и технологии» – (Handbook of Quantitative Science and Technology Research, Chapter 34 Kluwer Academic Publishers, 2005).

В несколько упрощённом переводе эту модель можно представить так: «Развивающиеся страны спешат заявить о том, что они обнаружили, а развитые страны спешат закрепить за собой свои права на обнаруженное, поэтому соотношение патентов к публикациям – это объективный уровень развития страны».

Рис. 4. Соотношение количества патентов (вертикальная шкала)

к числу статей на миллион жителей (горизонтальная шкала) в двойном логарифмическом масштабе. Чёрные квадраты – развивающиеся страны, кружки – промышленно развитые страны.

(Оригинал – Handbook of Quantitative Science and Technology Research, Chapter 34 Kluwer Academic Publishers, 2005. – P. 769.)

Неудивительно, что в последнее время на правительственном уровне формулируются очень конкретные и решительные меры в попытке исправить ситуацию. В Указе Президента РФ от 7 мая 2012 г. № 599 «О мерах по реализации государственной политики в области образования и науки» ставится задача «обеспечить достижение следующих показателей в области науки – увеличение к 2015 году доли публикаций российских исследователей в общем количестве публикаций в мировых научных журналах, индексируемых в базе данных «Сеть науки» (Web of Science), до 2,44%».

Столь же решительно попытались решить проблему Законопроектом № 305828-6 «О Российской академии наук, реорганизации государственных академий наук и внесении изменений в отдельные законодательные акты Российской Федерации».

Чтобы представить объём работ по выполнению Указа, следует внимательно разобраться в том, какие позиции наша страна занимает сейчас.

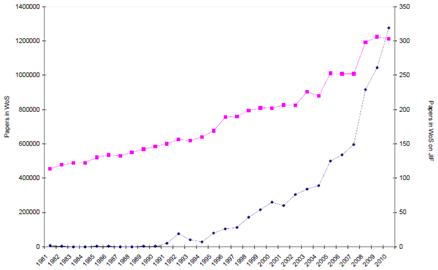

Рост публикаций по журнальному импакт-фактору в мире (что отражает интерес к этой проблеме) иллюстрирует график (рис. 5), заимствованный из доклада, посвящённого изучению импакт-фактора (Analysis of journal impact factor Research in time: development of a Specialty?), Тэда ван Люйвена (Thed van Leeuwen) и Поля Вутерса (Paul Wouters) из Центра изучения науки и техники Лейденского университета (Нидерланды) на Венской конференции.

Рис. 5. Динамика роста общего

количества статей в Web of Science за 1981–2010 гг.

(розовые точки, левая шкала) и статей по импакт-фактору (синие точки, правая

шкала)

(Оригинал: http://www.issi2013.org/Images/ISSI_Proceedings_Volume_I.pdf page 68)

Очень часто можно услышать, что серьёзным препятствием к широкому узнаванию, пользованию и цитированию российской научной периодикой является разница в языке. Это так, но в то же время заметим, что, во-первых, в течение многих лет более сотни наиболее авторитетных российских научных журналов переводится на международный язык общения и английская версия выходит одновременно с русской. И во-вторых, как оказалось, язык – не препятствие, учёные неанглоязычных стран успешно продвигаются на международной арене. В доказательство приведу динамику изменений за 1997–2010 гг. количества журналов, индексируемых и отражаемых в системе JCR (Journal citation reports JCR by Reuters) – продукции компании «Reuters» (табл. 2). Материал заимствован из доклада испанских специалистов Эльбы Малеон (Elba Mauleon) и Даниэлы де Филиппо (Daniela De Filippo) «Повышают ли страны БРИК и МИТС своё присутствие на международной сцене?» (Are the BRIC and MITS countries improving their presence in the international science?). (При адаптации таблицы для этого обзора оставлены только данные о публикациях по естественным и техническим дисциплинам.)

Таблица 2

Количество

периодических изданий,

регистрируемых в системе JCR в 1997, 2004 и 2010 г.

(Приведены данные для трёх групп

стран: БРИК, МИТС и G7.)

|

Cтрана |

Год |

||

|

1997 |

2004 |

2010 |

|

|

Всего журналов в системе JCR |

4963 |

5969 |

8073 |

|

Страны БРИК |

|||

| Бразилия |

9 |

16 |

89 |

| Россия |

96 |

104 |

147 |

| Индия |

37 |

47 |

94 |

| Китай |

20 |

71 |

138 |

|

Страны МИТС |

|||

| Мексика |

5 |

7 |

28 |

| Индонезия |

0 |

0 |

0 |

| Турция |

1 |

3 |

49 |

| Южная Корея |

6 |

27 |

75 |

|

Страны G7 |

|||

| Германия |

381 |

427 |

545 |

| Канада |

73 |

75 |

94 |

| США |

1915 |

2289 |

2724 |

| Франция |

153 |

143 |

189 |

| Италия |

51 |

65 |

121 |

| Япония |

133 |

160 |

207 |

| Великобритания |

999 |

1267 |

1592 |

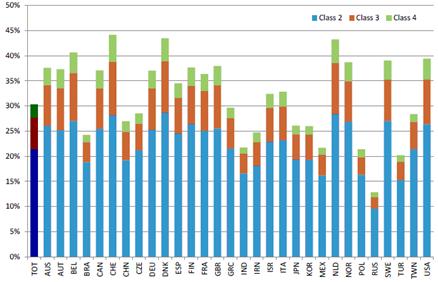

К сожалению, качество наших статей оставляет желать лучшего. На Венской конференции в докладе представителя Центра мониторинга науки бельгийского Католического университета в Лувене Вольфганга Глянцеля (Wolfgang Glanzel) «Применение методики группирования научных статей по классам на основе их цитирования. Тематические и междисциплинарные оценки для разных стран» («The application of citation-based Performance classes to the Disciplinary and multidisciplinary Assessment in national comparison») показано (рис. 6; оригинал – http://www.issi2013.org/Images/ISSI_Proceedings_Volume_I.pdf page 119): подавляющая часть статей из России (87% в пятилетнем окне цитирования с 2007 по 2012 г. и столько же – в трёхлетнем окне цитирования с 2009 по 2012 г.) входит в класс 1, т.е. работы очень невысокого качества (в сравнении с публикациями из других стран).

Рис. 6. Оценка качества (уровня

цитируемости) научных статей из 30 стран

по данным системы Web of Knowledge. Суммарные данные за 5 лет

2007–2012 гг.

Доля наиболее цитируемых статей (4-й класс) выделена зелёным, далее по убыванию цитирования: 3-й класс – розовым, 2-й класс – голубым; доля наименее цитируемых статей – незакрашенный остаток (до 100%). В первой слева колонке приведены средние данные по миру. Сокращённые названия стран указаны, как принято ЮНЕСКО (оригинал см.: http://www.issi2013.org/Images/ISSI_Proceedings_Volume_I.pdf page 119).

Такие страны, как Бельгия, Дания, Голландия и Швейцария, выпускают наибольший объём качественных статей 4-го класса (и у них же наименьшая доля работ класса 1); за ними следуют Норвегия, Швеция, Великобритания и США. Россия занимает стабильно низкую позицию.

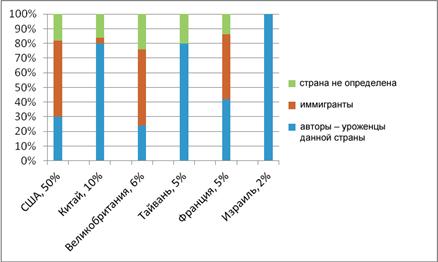

На основании изучения автобиографий и коротких биографий (CVs or Short Bios), в основном опубликованных в Интернете, японские учёные Ясухиро Ямащита (Yasuhiro Yamashita) и Дайсуке Иошинага (Daisuke Yoshinaga) из университета Ямагата (Yamagata University) в докладе «В какой мере можно проследить интернациональное перемещение учёных на основе опубликованных источников?» (To what extent can researchers’ international movement be grasped from published data sources?) представили необычайно интересные, можно сказать увлекательные, результаты.

Они проанализировали две группы учёных: в первую вошли те, кто за период с 2004 по 2006 г. (период выбран с учётом времени запаздывания цитирования) опубликовали высокоцитируемые работы (по данным Web of Science на январь 2011 г.) по тематике компьютерных наук и искусственного интеллекта (Computer Science, Artificial Intelligence); во вторую – те, чьи работы за тот же период не цитировались ни разу.

К высокоцитируемым отнесены работы, входящие в первый 1% цитирования; нецитируемые работы определены методом случайной выборки, а количество их в выборке примерно равно количеству статей в первой группе. Некоторые иллюстрации к этому докладу (в переводе и переработке) – рис. 8–12.

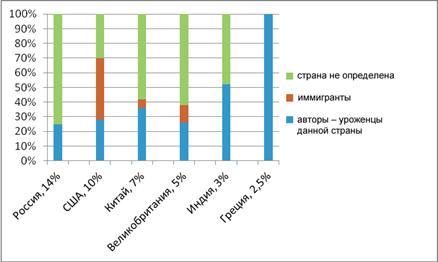

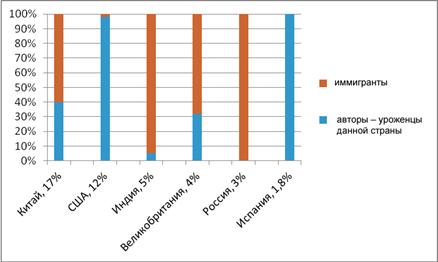

Рис. 7. Доля

высокоцитируемых и нецитируемых авторов:

работающие в своём отечестве (красный), сменившие страну (зелёный)

и те, место работы которых не определено (синий)

На основе данных рис. 7 можно сделать выводы: в своём отечестве публикуется 43–44% авторов; среди высокоцитируемых вдвое больше эмигрантов, а для нецитируемых вдвое труднее установить место их пребывания. Более развёрнутые данные о роли учёных, работающих в своей стране, и приезжих специалистов – на рис. 7–11.

Рис. 8. Доля высокоцитируемых

публикаций по странам,

в которых работают авторы. (После названия страны указана её доля

высокоцитируемых публикаций в их общем объёме.)

Как показали MacRoberts & MacRoberts (2010), малоцитируемые статьи не обязательно оказываются малоиспользуемыми. Многие работы, опубликованные учёными из российских НИИ, не учтены в упомянутом выше исследовании японских авторов. Российские учёные публикуют свои статьи в «Journal of Computer and Systems Sciences International» – английском переводе отечественного теоретического журнала.

Рис. 9. Распределение числа

нецитируемых публикаций по странам,

в которых работают авторы. (После названия страны указана доля

нецитируемых публикаций в их общем объёме.)

Рис. 10. Распределение числа

высокоцитируемых публикаций по месту проживания

и работы авторов. (После названия страны указана доля высокоцитируемых

публикаций, подготовленных жителями данной страны, в общем их объёме.)

К малоцитируемым статьям относятся публикации исследователей из России (13,3%), США (10,4%), Канады (7,1%), Италии (6,9%) и Китая (6,8%). На рис. 10 и 12 показано распределение по странам нецитируемых (ни одного цитирования) статей. В России, Италии, Турции и Греции они подготовлены авторами из этих стран или теми, чьё происхождение не указано. В США и Канаде – это иммигранты.

Россия не публикует высокоцитируемые работы, в то же время активно работает с зарубежными издателями, но очень мало издаёт труды зарубежных учёных. Индия, напротив, «поставляет» высокоцитируемых учёных в другие страны, а малоцитируемые работы публикует у себя.

Уже в 1999 г. 56% материалов Института атомной энергии им. И. В. Курчатова изначально публиковались на английском языке.

Рис. 11. Распределение числа

нецитируемых публикаций по месту проживания

и работы авторов. (После названия страны указана доля нецитируемых публикаций,

подготовленных жителями данной страны, в их общем объёме.)

Исследователи большинства стран, за исключением США, высокоцитируемые статьи публикуют в других странах, а малоцитируемые – в основном у себя на родине. Американцы все свои ценные материалы издают в США, а высокоцитируемые авторы из других стран стремятся уехать из своей страны.

Два азиатских гиганта научных публикаций – Китай и Индия – ведут себя по-разному: китайцы пропорционально публикуют хорошие и средние статьи у себя, а индусы – высокоцитируемые публикуют за рубежом, а плохонькие – дома. Исследователь Джонкерс (Jonkers) в 2008 г. отмечал, что Китай имеет специальные программы по возвращению уехавших учёных.

Для любознательных отметим ещё некоторые факты: рассмотрение значения, или роли, коллективного творчества показало, что наиболее продуктивны авторские коллективы, состоящие из двух-трёх человек; средний стаж (время работы) авторов высокоцитируемых статей – 15,8 лет (15,1 – для переехавших из других стран, 16,2 – для «домоседов»), а малоцитируемых – 18,6 (18,4 – для переехавших, 18,7 - для «домоседов»).

Краткий страноведческий анализ библиометрических данных и сравнение публикационной активности разных стран завершу выдержками из постерного доклада на Венской конференции «Научные тренды в генетике: наукометрические профили некоторых азиатских стран» (Research trends in genetics: scientometric profile of selected Asian countries) группы индийских авторов – Шиваппа Сангам (Shivappa L. Sangam), Ума Арали (Uma B. Arali), Чандрасекар Пати (Chandrashekhar G. Pati), Сришаил Гани (Srishail Gani), работающих в университете Карнатак в Дарваде (Karnatak University, India).

По данным системы PubMed за период 2002–2011 гг. опубликовано множество статей по 16 специальностям генетики – молодой и быстро развивающейся науки (табл. 3).

Таблица 3

Количество статей, опубликованных

учёными разных стран

по 16 специальностям генетики за

2002–2011 гг. (данные системы PubMed)

|

Страна |

Количество статей |

| Япония |

130 060 |

| Китай |

115 689 |

| Индия |

26 456 |

| Израиль |

22 033 |

| Тайвань |

21 970 |

| Грузия |

9 421 |

| Турция |

7 412 |

| Южная Корея |

6 498 |

| Гонконг |

5 968 |

| Россия |

5 832 |

Великолепный обзор «Публикационная активность, возможности роста научного продукта и традиционный русский вопрос “Что делать?”» опубликовал в октябрьском и ноябрьском номерах 2013 г. журнала «Университетская книга» П. Г. Арефьев, главный специалист Национального Фонда подготовки кадров.

Задача довести к 2015 г. долю российских научных публикаций в мировом потоке до 2,44% – достаточно сложна и амбициозна, и автор анализирует оптимистические и пессимистические сценарии достижения поставленной цели.

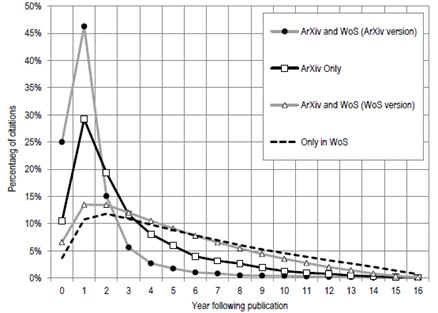

К сожалению, нужно учитывать, что идёт уже 2014 г. и существует неустранимый определённый временной лаг (запаздывание) между написанием статьи и её опубликованием (от нескольких месяцев до года), а также запаздывание между датой публикации и началом цитирования. Как пример, приводим рисунок, заимствованный из доклада «Как влияют статьи, непроиндексированные крупными системами, на статистику в общественных науках» (Do non-source items make a difference In the social sciences?), представленного Пэй Шан Чи (Pei-Shan Chi) из Института научной информации и контроля качества в Берлине (Institute for Research Information and Quality Assurance, Berlin, Germany) на Венской конференции (рис. 12).

Рис. 12. Динамика цитирования

статей по общественным наукам;

(обработано 1 015 публикаций

университетов Манхейм и Мюнстер, ФРГ,

за 2003–2007 гг.; данные взяты

из Web of Science)

Динамика цитирования различных типов документов – печатных (WoS), электронных (arXiv only), гибридных (одновременно существуют печатная и электронная версии) – показана на рис. 13. Это один из рисунков к глубоко продуманной статье «Детальное изучение использования электронных препринтов: на примере сетевого архива arXiv» (The nuanced nature of e-print use: a case study of arXiv) канадско-англо-американского коллектива авторов: Винсента Ларивьер (Vincent Lariviere), Бенуа Массалу (Benoit Macaluso), Кэссиди Сугимото (Cassidy R. Sugimoto), Стаси Милоевич (Stasa Milojevic), Блэза Кронина (Blaise Cronin), Майка Тилвола (Mike Thelwall).

Для электронных документов пик цитирования наступает через год после подачи в архив; печатные работы цитируются активнее через два года после опубликования. Цитирование электронных документов снижается более быстрыми темпами.

Рис. 13. Динамика цитирования

(1995–2010 гг.) различных типов документов:

печатных (WoS), электронных

(arXiv only) и гибридных (одновременно существуют

печатная и электронная версии –

верхняя кривая)

(Оригинал по адресу: http://www.issi2013.org/Images/ISSI_Proceedings_Volume_II.pdf page 1330)

Библиометрия как массовая наука существует более 60 лет, если считать с момента основания Института научной информации (Institute for Scientific Information – ISI) и выпуска первого издания указателя «Science Citation Index».

Изначально банк данных ISI задумывался в качестве инструмента наукометрии для тех или иных отраслей знания, а также для определения соответствующего круга специалистов. Однако вскоре учёные поняли значение этого банка данных и для социологических исследований, изучения истории науки, оценки научных учреждений и даже продуктивности и эффективности деятельности отдельно взятых учёных.

Система индикаторов показателей активности и результативности научных исследований разрабатывалась в 1970-е гг., однако внедрение её откладывалось до тех пор, пока (через какое-то время) не понадобилось осуществлять контроль эффективности работы факультетов, продуктивности отдельных учёных и проводить сравнительный анализ деятельности университетов. Такое время настало, когда при общем снижении расходов вместо поддержки университета или НИИ в целом была введена иная система финансирования, предполагающая поддержку конкретных научных программ.

Привлекательность использования простых количественных показателей очень высока не только для государственных чиновников и администраторов, но и для руководителей университетов, сотрудников благотворительных фондов, членов учёных советов, т.е. представителей того самого научного сообщества, которое так яростно и всеми доступными средствами сопротивлялось введению оценок со стороны внешних организаций.

Тридцать лет тому назад, в 1983 г., Б. Мартин и Дж. Ирвин опубликовали в Великобритании первые оценки результативности работы исследовательских институтов, выполненные на основе библиометрии (Martin B. R., Irvine J. Assessing basic research – some partial indicators of scientific progress in radio astronomy. – Research Policy 12 (2): 61–90). В то время реакция учёного мира оказалась в основном негативной. Научные работники не могли согласиться с самой основой использованной методики и грозились вызвать авторов аналитического исследования в суд, поскольку опасались негативных последствий этого анализа.

По мнению уже упоминавшегося О. Уткина, роль библиотек в анализе научной деятельности организации можно определить следующими параметрами: выбор инструмента анализа – 50%; работа по организации и сопровождению доступа – 25%; работа с конечными пользователями по их обучению и поддержке – 15%; подготовка совместно с департаментом науки аналитических материалов – 10%.

Можно предполагать, что смещение в пользу количественной библиометрии произошло из-за утраты веры в справедливость научного рецензирования. Анализ показал: рецензенты финансирующих агентств были более единодушны в негативных оценках, когда рекомендовали не выделять средства на то или иное исследование. Но при выражении поддержки их мнения резко расходились. При этом непосредственно в издательствах, положительные мнения рецензентов о статьях в основном совпадают, однако часто расходятся при отклонении материала.

Питер Вайнгаарт (Peter Weigaart) из Института исследования науки и техники (Университет г. Билефельд, Германия) в докладе «Оценка результатов научных исследований: опасность манипулирования цифрами» (Evaluation of Research performance: the danger of numbers) на 2-й Международной конференции в Центральной библиотеке Научного центра Юлих «Библиометрический анализ в науке и исследованиях. Применения, преимущества и ограничения» (5–7 ноября 2003 г.) высказал свою точку зрения: «Использование данных цитирования базируется на том предположении, что при достаточно большом количестве найденных ссылок различные мотивации, служащие стимулом для цитирования той или иной статьи, взаимно нейтрализуются, и то, что остаётся – это сам факт внимания к указанной статье. В различных отраслях науки сложились очень разные обычаи цитирования. Статьи о результатах основных биомедицинских исследований цитируются в шесть раз чаще, чем статьи по математике».

Некоторые учёные искусственно увеличивают число своих публикаций, разбивая текст статьи на «минимально допустимые» в данном издательстве единицы. Они также могут активно продвигать и разрабатывать консервативные или даже устаревшие, но надёжные и простые проекты и вполне могут существенно снизить требования к подготовке выпускаемых у них кандидатов и докторов наук.

Исследование, выполненное в Австралии, показало: при управлении финансированием на основе количества публикаций в авторитетных журналах число статей значительно возросло, однако же их качество (если судить по индексам цитирования) отнюдь не выросло.

Эффект усиленной коммерциализации ISI, проводимой новым владельцем этого института – группой компаний «Томсон» (Thomson Company of Toronto), характеризуется несколькими аспектами. Во-первых, с рынка оказались вытесненными все независимые небольшие группы квалифицированных аналитиков, которые пользовались базами данных ISI для проведения оценок и уточнения исходных данных в соответствии с определённым конкретным заказом. Во-вторых, легко доступными стали, казалось бы, точные показатели, и предполагается, что любой человек может участвовать в оценке той или иной работы учёного.

Для оценок перспектив публикаций в сетевых системах интересно рассмотреть соотношение динамики цитирования и динамики выгрузок. На рисунке 14 (а, б) показана динамика цитирования и выгрузки исходных документов как функция от года публикации и от научной дисциплины (фармакология, токсикология, медицина). Это иллюстрации к докладу на конференции в Вене испанских учёных Винсента Герреро-Ботэ (Vicente P. Guerrero-Bote) и Феликса Мойа-Анегон (Félix Moya-Anegón) «Соотношение между выгрузкой и цитированием и влияние языка документа» (Relationship between downloads and citation and the influence of language).

Издания по различным дисциплинам «ведут себя» в целом одинаково. А вот разница между динамикой цитирования (плавный рост за 2–3 года до максимальных значений и довольно медленный спад) и темпом выгрузки (немедленное начало и быстрый спад интереса) очень характерна и говорит в пользу формирования сетевых архивов открытого доступа.

По мнению Питера Вайнгаарта, библиометрические и другие подобные индикаторы должны применяться профессионалами, имеющими опыт работы с сырыми данными (данные ISI – это именно сырые, неочищенные и непригодные для глубокого и серьёзного анализа в других странах). Такие данные могут использоваться только в условиях агрегирования (кумулирования), при котором законы больших чисел помогают сглаживать случайные статистические ошибки и флуктуации. Их надо использовать в комбинации с качественными оценками, полученными методом научного реферирования, при этом желательно, чтобы референты были из тех же институтов и учреждений.

Призыв к осторожности при использовании библиометрических данных прозвучал и в докладе (упомянутой выше конференции в Юлихе) известного специалиста по библиометрии Майка Тилвола (Mike Thelwall) из университета Вулвергемптона (Великобритания): «Цитирование осуществляется по очень многим причинам, зачастую не имеющим отношения к значимости цитируемых работ, например, могут цитировать с целью раскритиковать или заявить, что и другие исследователи работают над той же проблемой, а может быть, чтобы просто показать, что автор им известен. Тем не менее многочисленные исследования подтверждают, что учёт цитирования может быть полезным, но в интерпретации результатов, полученных этим методом, следует быть очень осмотрительным и не попадаться в хорошо известные ловушки – например, различные традиции цитирования, сложившиеся в научных дисциплинах. Нужно чтобы сравнение проводилось только в рамках одной и той же отрасли науки».

Рис. 14 а, б. Соотношение динамики цитирования и динамики выгрузок как функция от года публикации и от научной дисциплины (фармакология, токсикология, медицина)

(Оригинал см.: http://www.issi2013.org/Images/ISSI_Proceedings_Volume_II.pdf page 1474)

Ряд исследователей указывает на связь между цитированием и формированием сетевых гиперссылок; они полагают, что количество ссылок на данную сетевую страницу (или на группу сетевых страниц) может быть полезным индикатором значимости сетевого ресурса. Сетевая страница, на которую сделано множество ссылок, может считаться намного важнее той, которую все игнорируют. Тем самым создаются предпосылки для расчёта сетевого импакт-фактора (если угодно – веб-импакта) на базе количества имеющихся сетевых ссылок.

В силу того, что сейчас многие исследователи или университетские факультеты и университеты) активно публикуются в Сети, приоткрывается дверь для создания нового типа библиометрических замеров. Более 90% ссылок появились как следствие научной активности; менее 1% имели целью непосредственное цитирование конкретных журнальных статей. В типичной ситуации гиперссылки встречались в контексте страниц, связанных с процессом обучения, или на страницах, содержащих общую информацию об исследованиях.

Итог изучения сетевых страниц – убеждённость в том, что гиперссылки не следует рассматривать в качестве прямого аналога библиографических ссылок (цитирования). Они скорее представляют собой некий новый вид неформального научного общения. Основная причина появления большого количества гиперсвязей – высокий рейтинг университетов, т.е. творческая продуктивность. Однако к качеству содержания опубликованных материалов количество гиперсвязей отношения не имеет. Другими словами, более продуктивные университеты просто стараются больше публиковаться в Сети, но то, что они публикуют, само по себе по отдельности не привлекает особого интереса или не вызывает роста гиперссылок к конкретной статье.

Выводы

1. Нужно учитывать, что существует определённый временной лаг (запаздывание) между временем написания статьи и её опубликования (в печатном варианте – от нескольких месяцев до года), а также запаздывание между датой публикации и началом цитирования.

2. Для электронных документов пик цитирования наступает через год после подачи в архив; печатные работы цитируются активнее всего через два года после опубликования. Цитирование электронных документов снижается быстрее.

3. Библиометрические индикаторы поддерживают результаты реферирования и могут скорректировать их в том случае, если индивидуальные оценки вступают в противоречие с агрегированными данными. С другой стороны, и библиометрические данные также могут быть скорректированы суждениями референтов в том случае, если формальные алгоритмы почему-либо не работают. Это объединение библиометрических методов с рецензированием, так называемое информированное рецензирование, может служить целям обеспечения прозрачности для широкой публики и в то же время сохранять все признаки научного подхода.

4. Измерения на базе цитирования оказываются действенными только при работе с большими массивами публикаций.

5. Исследование изменений в организации университетской науки при её финансировании на базе библиометрии показало, что основные направления этих изменений состоят в следующем: наращивание количества в ущерб качеству; стремление получить сиюминутные, кратковременные преимущества, а не создавать прочный фундамент для долговременного высококачественного продвижения; стремление соблюсти условности, а не разобраться в сути дела.

6. В условиях библиометрических оценок учёные стараются:

7. Поставленная в Указе Президента РФ от 7 мая 2012 года № 599 «О мерах по реализации государственной политики в области образования и науки» цель повышения заметности научных результатов и увеличения роли российской науки на мировой арене может быть достигнута не только посредством наращивания массива печатных документов, представленных в Web of Science, – более эффективным и быстродействующим может быть наращивание массива документов в архивах открытого доступа.

8. Повышение публикационной активности российских учёных не изменит главного: российская наука недостаточно продуктивна. Наибольшую тревогу вызывает тот факт, что около 90% российских публикаций не цитируются ни разу. Если нет новых научных результатов, то возросшее количество публикаций окажется просто дополнительным бумажным мусором.